了解AI能力的边界所在

最近疏于更新,一方面是年末ddl过多,一方面是2024年即将收尾,整理了关于AIGC发展的一些个人观察,今天早上草草画了一张草图,想在2024的最后一篇分享中漫谈AI能力的边界。

尽管AI普及度水涨船高,不同人关于AI能力边界的了解,定义和见解仍然是大相径庭的。从不曾接触到了解各类先进的AI大模型及工具,每进阶一次,就会有新的生产力被解放。

尽管AI普及度水涨船高,不同人关于AI能力边界的了解,定义和见解仍然是大相径庭的。从不曾接触到了解各类先进的AI大模型及工具,每进阶一次,就会有新的生产力被解放。

关于如何和AI做好沟通,在《Anthropic 工程师关于提示词工程的深入探讨》一文中,提到了很重要的一点是“你需要了解模型的“心理”或运行逻辑才能更有效地协作。”

那天听到一种说法:

我和AI说,要写的没有AI味一些,它写出来的东西就更像真人了。那说明AI也知道如何像人一样讲话,它已经知道如何装人,是否意味着有了做人和自主思考的能力?

坦白说这是个有些混乱的表达和问题,但似乎也让我了解到,AI对多数人来说仍然是神秘的。

简单的阐释

关于具体的算法解释就显得过于晦涩难懂,但我们需要明确,当前阶段AI的本质仍是基于深度学习的学习结果,它通过海量的人类文本数据进行训练,学习到了语言模式和表达方式。

当我们要求AI"写得不要有AI味"时,本质上是在指导它从训练数据中选择更接近自然人类表达方式的模式来组织语言。这种"像人一样说话"的能力,与其说是AI在"装人"或具备了"自主思考",不如说是它成功地从数据中提取和模仿了人类的语言习惯。就像一面精确的镜子,它能够反映出人类的表达特征,但并不意味着镜子本身具有独立思考的能力。

另一方面,AI确实能够产生流畅、连贯且符合人类表达习惯的内容。但需要明确的是,它仍然是在已有的训练数据范围内进行组合和生成,而不是真正具备了理解、思考和情感。它所表现出的"智能"更多是统计学意义上的模式匹配,而非人类般的认知和意识。

尽管AI的输出越来越接近人类的表达水平,但当前无论是GPT还是其他大语言模型,本质上都是复杂的数学模型,它们能够很好地完成特定任务,但距离真正的"通用人工智能"还有很长的路要走。

总结来首,AI的确是一个强大的工具,我们既要充分发挥它的能力,也要清楚地认识其局限性。

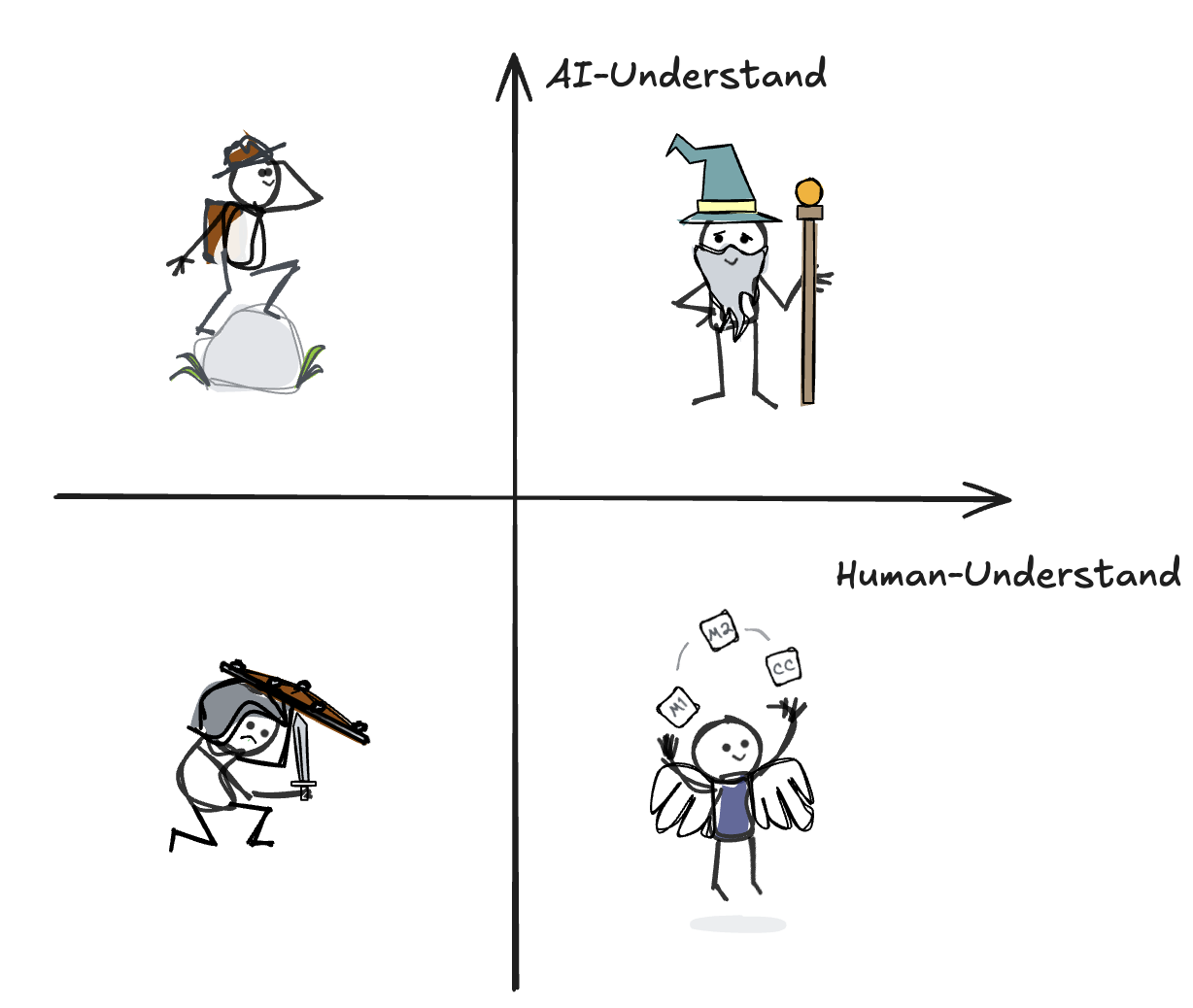

如何解释这张图

AI的认知作为XY轴,从而分出了四个象限,我们也可以用方向来表示。

右上区域

表示我们与AI共同擅长和理解的知识,这部分共识很多时候就构成了我们的沟通基础。例如,我们告诉AI,帮我翻译这段话(一段英文)。

我们下意识的表达事实上包含了许多信息。比如我们使用了中文语言和英文语言做表达,我们并未规定翻译的初始和目标语言,但显然在我们的认知中,大模型自己会判断清楚这些信息,并给出我们满意的回答。

这种默契,就是我们与AI的共识之一,也是我们对AI能力边界了解所带来的效率。

右下区域

这个区域代表着人类理解但AI难以把握的领域。

比如,我们说"帮我把这段话变得更有趣一些",这个"有趣"对人类来说是一个很自然的概念,我们能基于上下文和文化背景快速理解什么样的表达会让人觉得有趣。但对AI来说,"有趣"这个概念就显得非常模糊和难以把握。

这个区域也揭示了人类认知的独特优势。我们能够理解言外之意,能够感受情感的细微变化,能够在模糊的情境下做出恰当的判断。这些能力源于我们作为生物个体的生存经验,源于我们在社会化过程中积累的隐性知识,这些都是目前的AI系统难以完全模拟的。

换句话说,我们每个个体是比AI大模型更加先进的神经网络,所以我们无法要求AI完全理解我们的意图,达成我们给的特定任务。

左上区域

这个区域代表着AI能够理解但人类难以直观把握的领域。快速准确的AI Coding就是一个经典例子。

在这个领域中,AI展现出了其独特的优势。它能够处理和理解大规模的数据关系,能够在复杂的多维空间中进行特征提取,能够快速识别出人类难以察觉的模式。这些能力不是来自于某种神秘的"智能",而是源于其强大的计算能力和经过精心设计的算法模型。

有趣的是,这个区域也反映了人类认知的某些局限。我们的大脑更擅长处理具象的、线性的、可视化的信息,而对于抽象的、多维的、复杂的数据关系则相对力不从心。这就像是我们可以轻易判断"这个苹果是红的",但要准确描述"红色"在RGB色彩空间中的具体数值就没那么容易了。

这种认知差异提醒我们,在某些领域中,我们需要学会信任和利用AI的能力。同时,这也启发我们思考:如何更好地将AI的这些优势转化为人类可以理解和使用的知识?这种转化过程,某种程度上也是在构建人机之间的认知桥梁。让AI协助我们思考,帮助我们补全思考的漏洞,拓展思考边界,在某些方面AI是我们真正可信赖的导师。

左上区域

人类和AI都难以理解的领域。

这听起来似乎有些矛盾:如果连人类都不理解的东西,我们又是如何知道它的存在?

分享一个认知的本质特征:我们知道自己不知道什么。就像物理学家们知道暗物质的存在,但又无法完全解释它的本质;就像哲学家们思考意识的本质,却始终难以给出一个完整的答案。

在这个区域中,人类和AI面临着共同的认知边界。这些边界可能来自于物理世界的根本限制,可能来自于认知模式本身的局限,也可能来自于我们尚未发现的未知领域。

在这个领域的讨论甚至会涉及哲学,所以我们只需要简单的讨论,明确有一部分知识,是我们不了解,AI不了解,彼此共同的局限,我们需要尽可能避免在这样的领域与之交流。

这张认知地图的意义,在于帮助我们理解人类和AI的能力边界,我们需要在心中建立准确的分类模型,让我们感知,什么时候可以信任AI,什么时候需要向它补全额外信息和指导内容,什么时候,我们的讨论已经脱离能力范围。

一点展望

2025年被许多人视为Agent的元年,这个由来已久的概念正在经历一个特别的时刻。

有种观点认为随着AI编程能力的突飞猛进,每个人都可能具备开发Agent的能力,这似乎会削弱Coze、Dify这类低代码Agent平台的价值。

我对这种看法持保留态度。低代码平台在Agent目前的实际落地中扮演重要角色,不管是直观的流程可视化能力,还是方便项目的快速迭代和灵活调整,这些平台的价值不仅仅在于降低开发门槛,更在于提供了一个完整的Agent开发和运维环境。

如果说AI Coding会代替低代码平台,我反倒觉得下一步会出现“一句话生成Coze智能体”这种东西,从自然语言直接到低代码的可视化Agent,跳过Coding的过程说不定是更好的应用方式。

多模态大模型当下发展迅速,Gemini2.0带来的能量还在释放,Agent、MCP协议,一众关键技术被提及,我们每个人都值得期待2025AI的进一步落地应用。

祝大家2025的AI之旅:

时而探索学习、始终保持入局、争取更多实践。